목차

앞서 강력한 오픈소스 LLM(대규모 언어 모델) 플랫폼인 올라마(Ollama)를 터미널에서 사용하는 방법을 알아보았다.

2024.11.18 - [책 너머 인사이트/생성형 AI] - 올라마 (Ollama) 설치 완벽 가이드: 최신 AI 모델을 로컬에서 실행하는 방법

올라마 (Ollama) 설치 완벽 가이드: 최신 AI 모델을 로컬에서 실행하는 방법

이제 개인용 컴퓨터에서도 AI 모델을 실행할 수 있다. 그중에서도 Meta에서 무료로 배포하는 올라마 설치 방법을 알아보고자 한다. 올라마(Ollama)란?올라마 3.2는 메타에서 개발한 최신 대규모 언

booknbeyondinsights.tistory.com

터미널은 개발에 익숙하지 않은 사람들이 사용하기에는 어려울 수 있다. Docker와 Open WebUI를 활용하면 Ollama를 손쉽게 설치하고 ChatGPT와 유사한 인터페이스로 사용할 수 있다.

또한, 인터넷 없이도 사용할 수 있다.

이 글에서는 Docker를 사용해 Ollama와 Open WebUI를 설치하고 로컬 환경에서 AI 챗봇을 구축하는 방법을 알아보고자 한다.

Docker 설치하기

1. Docker에 접속한다.

Docker: Accelerated Container Application Development

Docker is a platform designed to help developers build, share, and run container applications. We handle the tedious setup, so you can focus on the code.

www.docker.com

2. 회원가입 후 [Download Docker Desktop]을 클릭해 OS에 맞게 설치한다.

3. 아래처럼 Docker 환경이 만들어졌다.

Open WebUI 설치하기

Open WebUI를 사용하기 위해서는 Python이 필요하다. 호환성 이슈로 인해 Python 3.11 이상의 버전을 사용해야 한다.

1. Open-WebUI 공식 문서를 참고한다.

https://github.com/open-webui/open-webui

GitHub - open-webui/open-webui: User-friendly AI Interface (Supports Ollama, OpenAI API, ...)

User-friendly AI Interface (Supports Ollama, OpenAI API, ...) - open-webui/open-webui

github.com

해당 문서에 Installation with Default Configuration 부분을 참고한다.

2. 앞서 올라마를 이미 설치했으니, 첫번째 명령어를 입력하면 된다. (Docker 이름을 바꾸려면 --name open-webui 에서 open-webui 를 변경하면 된다.)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

3. 해당 명령어를 터미널에 입력하면 설치가 완료된다.

4. 설치된 [Docker Desktop]을 클릭하면 open-webui 포트가 만들어 졌다.

Open-WebUI로 챗봇 시작하기

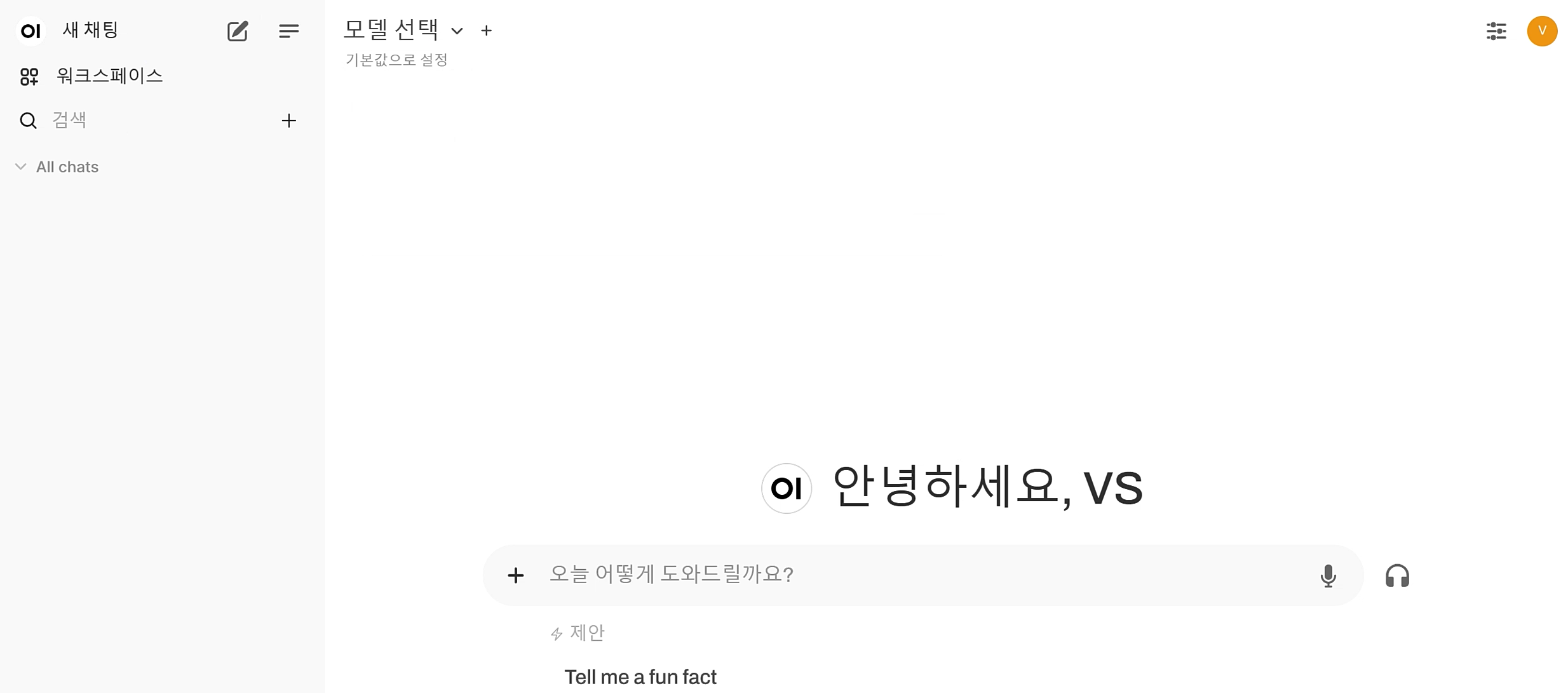

1. 주소창을 보면 로컬호스트에 접속된 걸 알 수 있다. Open WebUI에 회원 가입을 한다.

2. ChatGPT와 UI가 거의 동일한 화면이 보여진다.

3. [모델 선택]을 클릭하면, 내가 다운받은 모델과 기본 모델이 보여진다.(만약 모델이 보이지 않는다면, Docker Desktop으로 가서 새로고침하거나 포트를 다시 클릭해준다.)

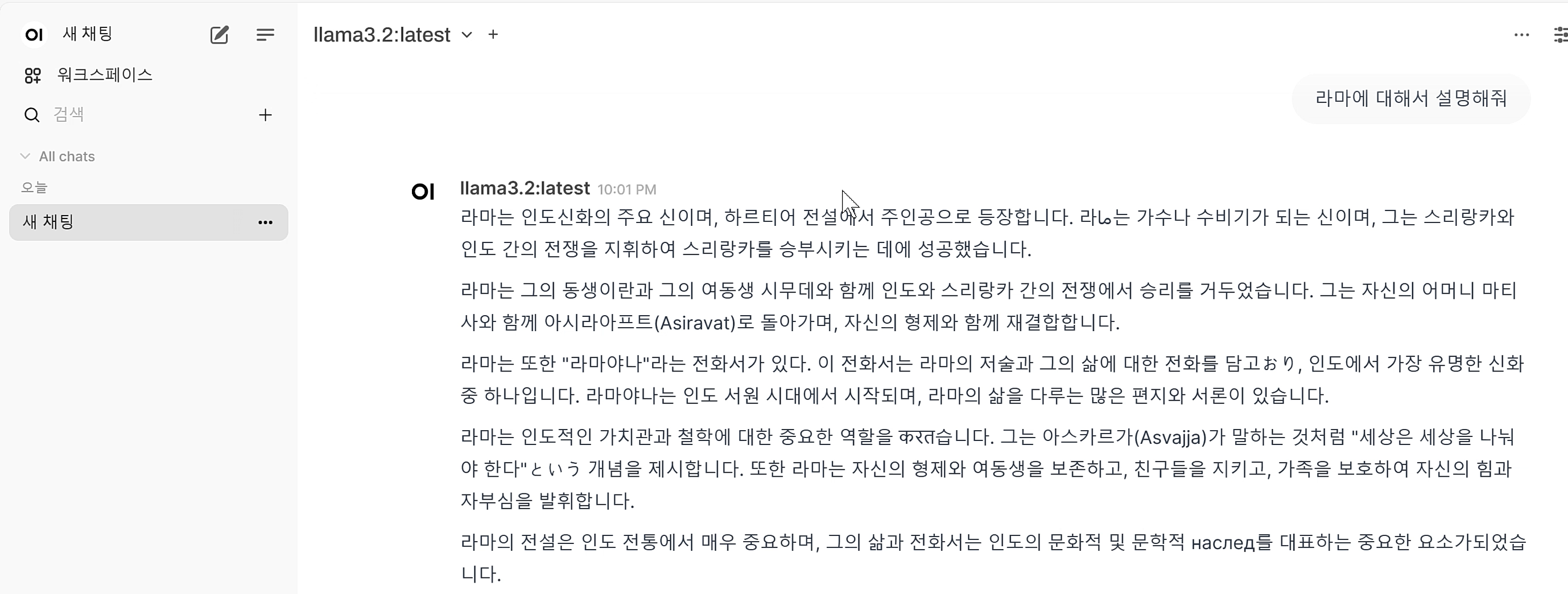

4. 원하는 모델을 클릭해 대화를 시작한다.

마무리

위에서 보다시피 llama3.2는 한국어에 약하다.

이는 한국어를 잘하는 모델을 Huggingface에서 다운로드하면 해결된다.

다음 포스팅에서는 Huggingface에서 모델 다운받는 방법과 올라마 WebUI 인터페이스 사용법을 알아보고자 한다.

'책 너머 인사이트 > 생성형 AI' 카테고리의 다른 글

| Guidde AI: 최첨단 비디오 문서화의 혁명 (1) | 2024.12.06 |

|---|---|

| ChatGPT로 맞춤형 챗봇 만들기 (1) | 2024.11.27 |

| 올라마 (Ollama) 설치 완벽 가이드: 최신 AI 모델을 로컬에서 실행하는 방법 (1) | 2024.11.18 |

| NotebookLM: Google의 혁신적인 AI 연구 도우미 완벽 가이드 (3) | 2024.11.11 |

| 퍼플렉시티 3개월 무료 구독권 받기 (2) | 2024.11.06 |